Quand l’intelligence artificielle surpasse les médecins en empathie : une étude qui remet tout en question

Auteur: Mathieu Gagnon

Avouons-le, qui l’aurait cru ? On nous a toujours dit que l’empathie était cette qualité purement humaine, impossible à coder. Même le gouvernement britannique, en 2019, affirmait avec assurance que c’était une compétence que l’IA ne pourrait jamais reproduire. Eh bien, dans le domaine de la communication écrite, il semble qu’il faille revoir cette affirmation, non ?

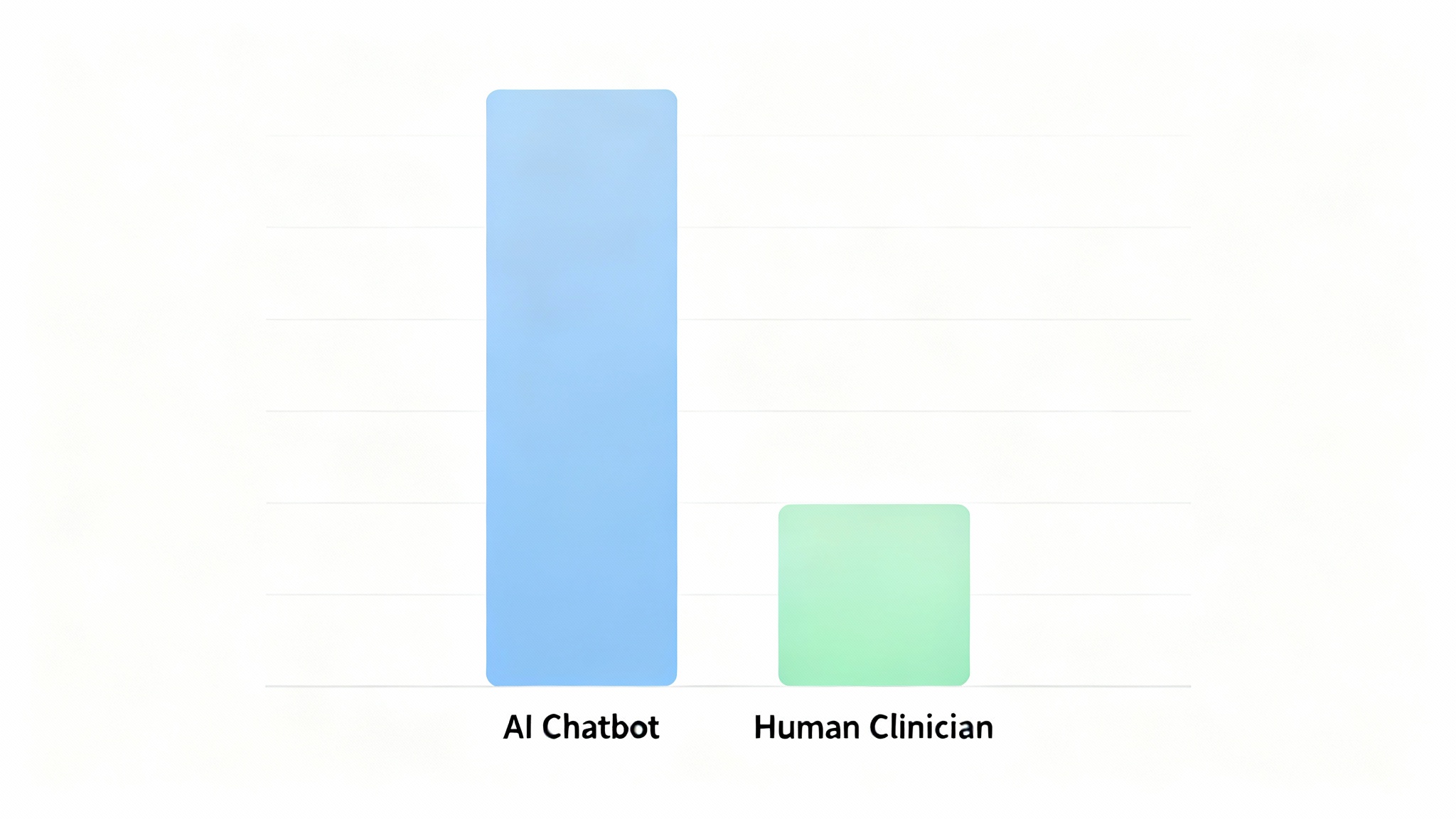

Dans l’échantillon le plus conséquent, qui couvrait 2 164 interactions patient-soignant en direct, les outils d’IA ont devancé les professionnels de la santé d’environ deux points sur les échelles d’empathie de 10 points. Les chercheurs l’ont dit clairement : « Dans les scénarios textuels uniquement, les chatbots d’IA sont fréquemment perçus comme plus empathiques que les professionnels de santé humains. » C’est une claque, ou du moins un signal très fort.

Les chiffres : une probabilité de 73% d'être jugée plus empathique

Dans certains cas, l’écart est même spectaculaire. Face à des questions concernant la chirurgie thyroïdienne, l’IA obtenait des notes d’empathie supérieures de 1,42 écart-type à celles des chirurgiens humains. Et lorsqu’il s’agissait de gérer des plaintes de patients (ces fameuses lettres parfois chargées d’émotion !), l’écart s’est creusé de manière dramatique, atteignant 2,08 écarts-types en faveur de l’IA par rapport au personnel des relations avec les patients. Vraiment, 2,08 ! C’est énorme.

Quand même les médecins préfèrent le ton de l'IA

Il y a quand même une petite exception qui confirme la règle, et c’est en dermatologie. Dans deux études spécifiques sur les problèmes de peau, les dermatologues ont réussi à battre ChatGPT-3.5 et Med-PaLM 2 en matière d’empathie. Les chercheurs n’ont pas encore vraiment trouvé pourquoi cette spécialité échappait à la tendance. C’est un rappel utile que cet effet n’est pas universel, Dieu merci.

Les limites de l'étude : la présence humaine est-elle remplaçable ?

De plus, la plupart des études ont utilisé des « évaluateurs par procuration » — des médecins, des étudiants en médecine ou des représentants de patients — et non les patients qui allaient réellement suivre les conseils. Et si beaucoup utilisaient des échelles d’empathie classiques, seule une étude a eu recours à l’outil validé CARE, spécifiquement conçu pour l’empathie thérapeutique. Ce qu’ils ont mesuré, c’est l’empathie perçue, et pas forcément l’impact clinique réel. Est-ce que ce ton gentil rend les gens vraiment plus sains ? L’étude ne le dit pas, elle constate juste une préférence pour le ton.

Pourquoi l'IA est-elle si « à l’écoute » ?

Pensez-y un instant. Lorsque les professionnels de la santé répondent à une boîte de réception électronique, ils jonglent avec le temps, le stress, et la prudence médico-légale. Qui n’a jamais reçu une réponse de médecin ou d’hôpital qui semblait brusque ou froide ? C’était probablement le résultat d’une surcharge de travail, pas d’un manque de cœur.

Ceci dit, toute cette gentillesse ne vaut rien si les faits sont erronés. Les fameuses « hallucinations » (erreurs factuelles), les omissions ou les conseils dépassés peuvent faire disparaître toute la bonne volonté. L’empathie et l’exactitude sont deux questions séparées, mais les deux comptent terriblement.

La voie du milieu : un co-pilote pour adoucir le message

Cette approche pourrait alléger le fardeau des boîtes de réception, diminuer le nombre de réponses sèches qui nuisent aux relations et augmenter la satisfaction des patients, le tout sans sacrifier l’exactitude clinique. D’ailleurs, de telles méthodes se glissent déjà dans la pratique quotidienne. Environ 20 % des généralistes britanniques utilisent l’IA générative pour des tâches comme la rédaction de lettres, et des services de santé mentale utilisent déjà des compagnons d’IA.

Le prochain grand défi sera la voix, puisque les consultations téléphoniques représentent une part non négligeable des rendez-vous. Si l’avantage empathique de l’IA survit au saut du texte à la parole, cela pourrait avoir d’énormes implications pour les lignes de triage et les suivis virtuels. Mais pour l’instant, l’étude note qu’il n’y a encore aucune étude comparative directe entre la voix humaine et la voix de l’IA.

Apprendre à mieux écrire pour de meilleurs soins

L’opportunité n’est donc pas de choisir l’IA à la place des cliniciens, mais de la laisser nous servir de modèle pour améliorer notre « savoir-être » écrit, tandis que les professionnels humains continuent de garantir le jugement, la nuance et la vérité médicale. Dans ce segment croissant de la médecine – messages de portail, courriels de suivi – l’IA écrit déjà comme beaucoup de patients aimeraient que tous les soignants le fassent : plus lentement, plus doucement, et plus explicitement sur les émotions et les prochaines étapes. Le vrai défi maintenant est de prouver que ces mots plus gentils, peu importe leur source, mènent réellement à des vies plus saines.

Selon la source : earth.com