Une révolution invisible : De nouveaux capteurs brisent les limites de l’optique

Auteur: Mathieu Gagnon

Quand l’informatique remplace l’œil

C’est fascinant de voir à quel point notre façon d’observer le monde a changé, vous ne trouvez pas ? Depuis des décennies, la technologie de l’imagerie nous a permis de tout voir, depuis la cartographie de galaxies lointaines grâce à des réseaux de radiotélescopes jusqu’aux détails microscopiques cachés à l’intérieur de nos cellules vivantes. Pourtant, il y avait toujours ce mur, cette barrière fondamentale qui persistait : la difficulté de capturer des images à haute résolution et à grand champ avec la lumière optique sans s’encombrer de lentilles lourdes ou de contraintes d’alignement strictes. C’était vrai… jusqu’à maintenant.

Une nouvelle étude vient de bouleverser la donne. Publiée dans la prestigieuse revue Nature Communications, cette recherche a été menée par Guoan Zheng, professeur d’ingénierie biomédicale, et son équipe du College of Engineering de l’Université du Connecticut (UConn). Je dois préciser que le professeur Zheng dirige également le Centre d’innovation biomédicale et de bio-ingénierie de l’UConn (le CBBI, pour les intimes). L’article original, écrit par Sarah Redmond et édité par Sadie Harley — avec une révision de Robert Egan, pour être tout à fait complet — détaille une solution de rupture qui pourrait bien redéfinir l’imagerie optique dans les sciences, la médecine et l’industrie. Rien que ça.

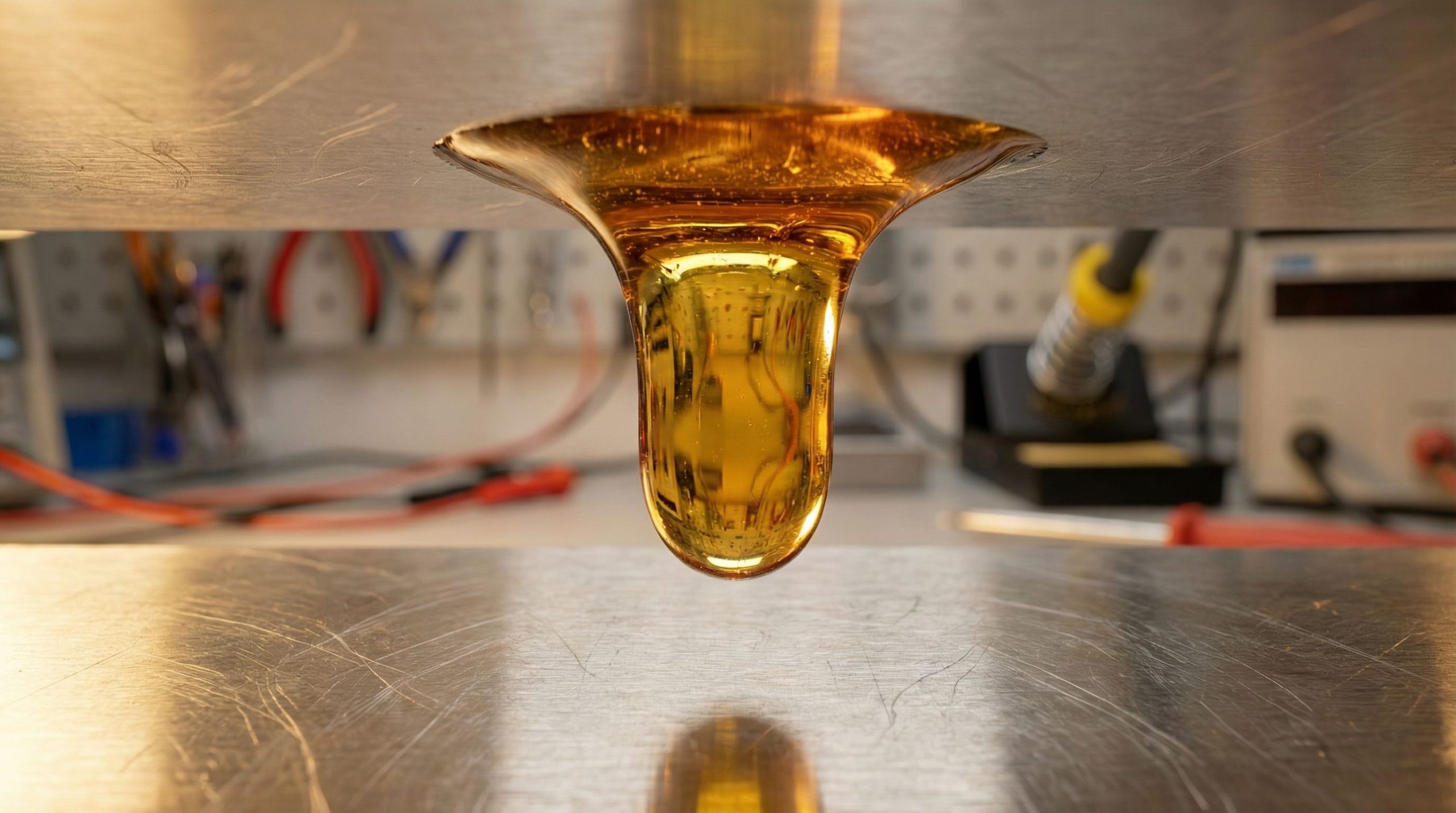

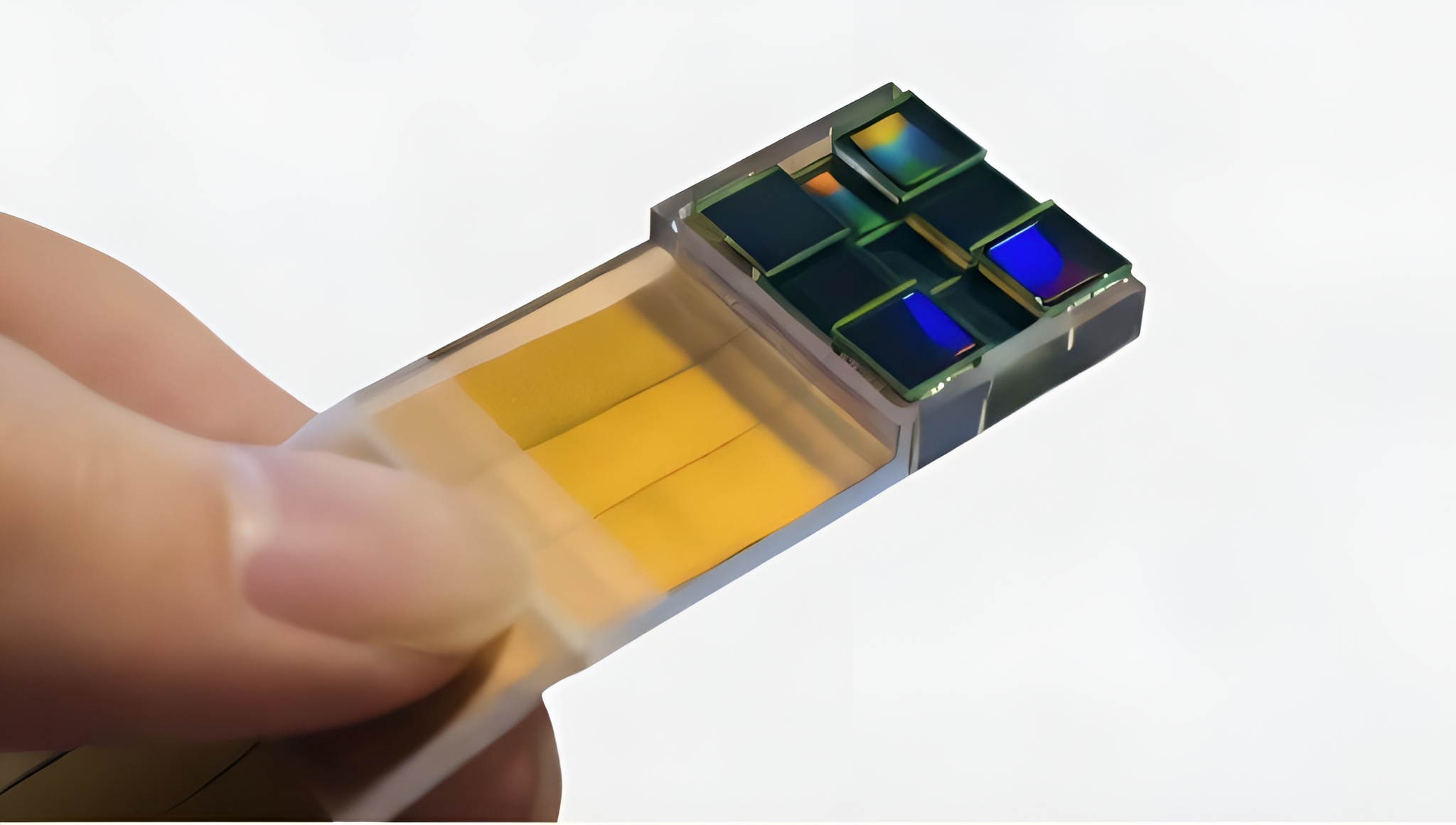

Le laboratoire du professeur Zheng a mis au point un nouveau capteur d’image capable d’atteindre une super-résolution optique… sans aucune lentille. L’inspiration est venue d’ailleurs, littéralement : ils se sont inspirés du réseau de télescopes qui a capturé la toute première image d’un trou noir. L’appareil utilise plusieurs capteurs travaillant de concert, fusionnant leurs observations par le calcul pour percevoir des détails plus fins. C’est un peu comme si l’ordinateur devenait la lunette.

Le défi technique et la réponse du MASI

Le professeur Zheng résume bien la situation : « Au cœur de cette percée se trouve un problème technique de longue date. » Il parle ici de l’imagerie à ouverture synthétique. C’est la méthode qui a permis à l’Event Horizon Telescope de photographier un trou noir en combinant de manière cohérente les mesures de plusieurs capteurs séparés pour simuler une ouverture d’imagerie beaucoup, beaucoup plus grande. En radioastronomie, c’est faisable, je dirais même presque courant, car la longueur d’onde des ondes radio est très longue, ce qui rend possible une synchronisation précise entre les capteurs.

Mais voilà le hic : avec les longueurs d’onde de la lumière visible, l’échelle qui nous intéresse est plus petite de plusieurs ordres de grandeur. Les exigences traditionnelles de synchronisation deviennent alors presque impossibles à satisfaire physiquement. Imaginez devoir aligner des instruments avec une précision nanométrique… C’est là qu’intervient le Multiscale Aperture Synthesis Imager, ou MASI pour faire court. Ce système prend le problème à bras-le-corps ou, devrais-je dire, le renverse complètement.

Plutôt que de forcer plusieurs capteurs optiques à fonctionner dans une synchronie physique parfaite — une tâche titanesque — le MASI laisse chaque capteur mesurer la lumière indépendamment. C’est ensuite, et seulement ensuite, qu’il utilise des algorithmes informatiques pour synchroniser les données. Zheng a expliqué que c’est comparable à avoir plusieurs photographes capturant la même scène, non pas comme des photos ordinaires, mais comme des mesures brutes des propriétés des ondes lumineuses. Ensuite, un logiciel assemble ces captures indépendantes en une seule image ultra-haute résolution. Ce schéma de synchronisation de phase informatique élimine le besoin de ces configurations interférométriques rigides qui empêchaient jusqu’à présent le déploiement pratique des systèmes optiques à ouverture synthétique. C’est malin, non ?

Comment ça marche : ondes, phases et balles de fusil

Le MASI s’écarte de l’imagerie optique conventionnelle de deux manières qui changent vraiment la donne. Au lieu de compter sur des lentilles pour concentrer la lumière sur un capteur, le MASI déploie un réseau de capteurs codés positionnés dans différentes parties d’un plan de diffraction. Chacun capture des modèles de diffraction bruts — essentiellement la façon dont les ondes lumineuses se propagent après avoir interagi avec un objet. Ces mesures contiennent à la fois des informations d’amplitude (la luminosité, si vous voulez) et de phase (la couleur, ou le délai de l’onde), qui sont récupérées grâce à ces fameux algorithmes.

Une fois que le champ d’onde complexe de chaque capteur est récupéré, le système effectue ce qu’on appelle un remplissage numérique (« digitally pads ») et propage numériquement les champs d’onde vers le plan de l’objet. Une méthode de synchronisation de phase informatique ajuste ensuite, par itérations successives, les décalages de phase relatifs des données de chaque capteur. L’objectif ? Maximiser la cohérence globale et l’énergie dans la reconstruction unifiée. C’est cette étape qui est l’innovation clé : en optimisant les champs d’onde combinés dans le logiciel plutôt qu’en alignant physiquement les capteurs, le MASI surmonte la limite de diffraction et d’autres contraintes imposées par l’optique traditionnelle.

Le résultat est une ouverture synthétique virtuelle plus grande que n’importe quel capteur unique, permettant une résolution sub-micronique et une large couverture de champ sans lentilles. Pour illustrer la puissance de la chose, l’équipe a imagé une douille de balle. Les données ont permis une reconstruction 3D à une résolution micrométrique, montrant l’impression du percuteur — une marque unique qui peut relier une douille à une arme spécifique. C’est incroyablement précis.

Conclusion : Un avenir sans lentilles ?

Les lentilles conventionnelles, qu’elles soient dans des microscopes, des caméras ou des télescopes, forcent les concepteurs à faire des compromis. Pour résoudre des caractéristiques plus petites, les lentilles doivent être plus proches de l’objet, souvent à quelques millimètres, ce qui limite la distance de travail et rend certaines tâches d’imagerie peu pratiques ou invasives. L’approche MASI se dispense entièrement de lentilles, capturant des motifs de diffraction à des centimètres de distance et reconstruisant des images avec une résolution allant jusqu’aux niveaux sub-microniques. C’est similaire, imaginez un peu, à pouvoir examiner les fines crêtes sur un cheveu humain depuis l’autre côté d’un bureau, au lieu de devoir le mettre à quelques centimètres de votre œil.

« Les applications potentielles pour le MASI couvrent de multiples domaines, de la science forensique et des diagnostics médicaux à l’inspection industrielle et à la télédétection », a déclaré Zheng. Mais ce qui l’enthousiasme le plus, c’est la scalabilité — contrairement à l’optique traditionnelle qui devient exponentiellement plus complexe à mesure qu’elle grandit, ce système s’adapte linéairement. Cela pourrait permettre de grands réseaux pour des applications que nous n’avons même pas encore imaginées. Le Multiscale Aperture Synthesis Imager représente un changement de paradigme : un monde où le calcul résout les limites fondamentales de l’optique physique. En remplaçant les lentilles encombrantes par des réseaux de capteurs contrôlés par logiciel, le MASI ouvre un nouveau domaine d’imagerie haute résolution, flexible et évolutif.

Ce contenu a été créé avec l’aide de l’IA.