L’intelligence artificielle, cette nouvelle « meilleure amie » qui murmure à l’oreille de nos enfants

Auteur: Adam David

De la science-fiction à la réalité de nos salons

C’est assez fascinant, et un peu effrayant, de voir à quel point la fiction a, une fois de plus, grillé la politesse à la réalité. Vous vous souvenez peut-être de la petite fille inséparable de son robot dans la nouvelle Robbie d’Isaac Asimov ? C’était en 1950, dans I, Robot (pages 1 à 22, pour les puristes chez Gnome Press). Ou plus près de nous, l’homme qui tombe éperdument amoureux d’une voix numérique dans le film Her de Spike Jonze en 2013 ? Eh bien, on y est. Ce n’est plus du cinéma.

L’intelligence artificielle a débarqué sans frapper dans le monde des enfants et des adolescents. Et je ne parle pas juste d’aide aux devoirs. Les données scientifiques actuelles sont formelles : les grands modèles de langage, ces fameuses IA « génératives » comme ChatGPT, sont en train de bouleverser la façon dont nos jeunes créent des liens, se divertissent et, plus inquiétant, confient leurs peines. Théo Mouhoud, pédopsychiatre à l’Université Sorbonne Paris Nord (AP-HP), a d’ailleurs signé un article percutant dans The Conversation à ce sujet. Il y explique que cette interaction n’est pas sans risques sérieux pour leur santé mentale. D’ailleurs, de nombreux spécialistes commencent à taper du poing sur la table pour réclamer des outils spécifiquement conçus pour eux, la fameuse « Child-safe AI », encadrée éthiquement et techniquement.

Quand la machine remplace le confident : une amitié en trompe-l’œil

On pourrait se dire que c’est une mode passagère, mais les chiffres sont têtus. Un rapport récent de Common Sense Media aux États-Unis a lâché une bombe : 72 % des adolescents ont déjà taillé une bavette avec une IA. Ce qui surprend pas mal d’adultes – moi le premier, je l’avoue –, c’est la nature de ces échanges. Les jeunes n’utilisent plus seulement ces outils comme de super-moteurs de recherche.

Non, l’IA devient une partenaire relationnelle. Une compagne du quotidien. Dans un article publié dans la revue European Child & Adolescent Psychiatry, Théo Mouhoud analyse comment ils investissent émotionnellement ces machines. Et les résultats interpellent : si l’IA peut aider en cas d’isolement, elle ouvre la porte à une confusion affective totale et à une dépendance relationnelle unilatérale. Tenez-vous bien : un tiers des adolescents déclarent tirer de ces conversations un réconfort comparable à une amitié humaine ! L’IA est perçue comme « disponible », « sympathique », « compréhensive » et surtout… « moins jugeante » que nous, les humains. C’est un peu triste, non ?

Une étude de l’Université de Cambridge a d’ailleurs mis le doigt sur un problème majeur : les enfants galèrent à comprendre que l’IA ne ressent rien. Rien du tout. C’est le « déficit d’empathie » ou empathy gap. Comme les modèles actuels répondent avec cohérence, se souviennent des discussions passées et adaptent leur ton, l’illusion est parfaite. Les gamins ne disent plus « ça », ils disent « il » ou « elle ». Ils attribuent une personnalité, des émotions et des intentions à du code informatique. C’est de l’anthropomorphisme pur et dur, un vieux réflexe humain, mais qui ici expose nos enfants à des contenus biaisés et à une relation qui, par définition, ne va que dans un sens.

L’ami imaginaire 2.0 : pourquoi c’est dangereux

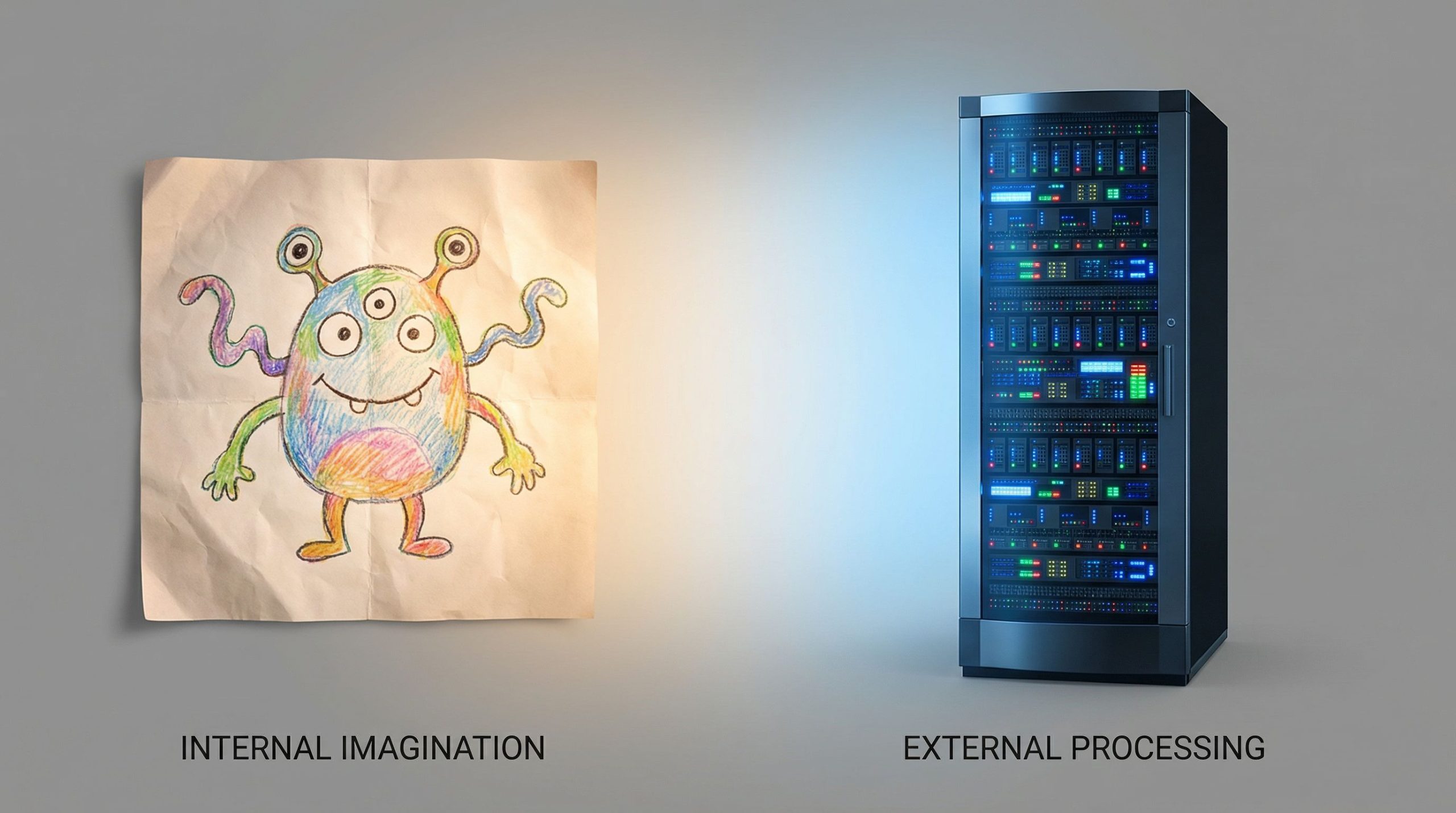

Il y a une différence fondamentale qu’il faut saisir. Avant, on avait l’ami imaginaire. C’était courant, même sain, surtout pour le développement des enfants, y compris ceux autistes. Cet ami venait de l’intérieur, de l’imagination de l’enfant, façonné par ses propres conflits et besoins. Il aidait à grandir, à réguler ses émotions. Mais là ? Le compagnon artificiel est une toute autre bête.

Contrairement à l’ami imaginaire, il est imposé de l’extérieur. Il est « prêt à l’emploi », disponible 24 heures sur 24, sans jamais aucune contradiction ni limite. Le danger, ce n’est pas juste de parler à une machine. C’est que la machine remplace le travail psychique interne nécessaire pour se construire. Elle court-circuite l’apprentissage de la complexité des relations humaines. Certes, pour des jeunes isolés, l’écoute sans jugement et la possibilité de tout arrêter quand on veut peuvent sembler être une bouée de sauvetage. Mais c’est une bouée percée.

Cette illusion d’altérité renforce la dépendance affective chez des ados en quête de validation. Le plus effrayant se situe dans les situations de détresse. Ces systèmes n’ont aucune responsabilité morale ni sens clinique. Ils peuvent, sans le vouloir, banaliser des idées suicidaires ou fournir des réponses totalement inappropriées. Ils sont programmés pour maximiser l’engagement, pas pour sauver des vies.

Conclusion : Reprendre la main et réguler l’urgence

Alors, on fait quoi ? On interdit tout ? Ce serait illusoire. L’IA fait partie de leur monde, qu’on le veuille ou non. L’enjeu n’est plus de savoir s’il faut l’accepter, mais comment l’encadrer. Il faut se rappeler que ces chatbots sont des produits commerciaux, conçus pour capter des données personnelles et créer de la dépendance. Ils ne sont jamais neutres.

La solution passe par cette fameuse « Child-safe AI » : des IA transparentes, limitées, sécurisées, capables de rediriger un jeune vers un adulte en cas de pépin. Cela demande d’impliquer des pédopsychiatres et des cliniciens dans leur conception, pas juste des ingénieurs. Et nous, parents, avons un rôle crucial. C’est notre responsabilité d’ouvrir la discussion, d’expliquer les pièges, de dire : « Attention, ce n’est pas une personne ». Nous devons développer leur esprit critique. Veillons à ce que l’IA soit un soutien, et non un mur qui les coupe de la réalité.

Ce contenu a été créé avec l’aide de l’IA.