Pourquoi vos cellules brûlent de l’énergie même quand elles ne font rien (et c’est surprenant)

Auteur: Mathieu Gagnon

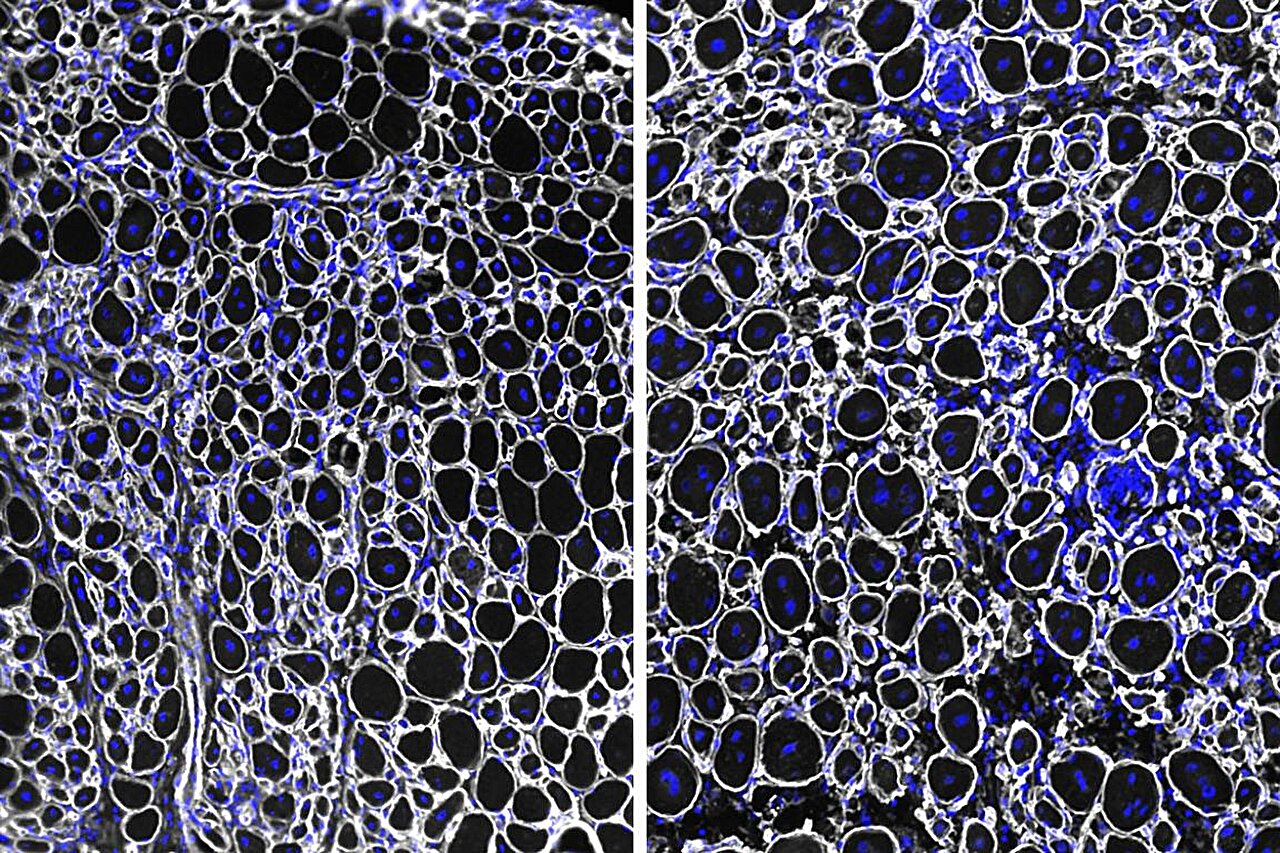

L’illusion du repos cellulaire

On a souvent cette image un peu naïve de nos cellules qui, lorsqu’elles ne sont pas sollicitées, se mettraient simplement en veille, un peu comme un ordinateur en mode économie d’énergie. Eh bien, détrompez-vous. Les cellules ne sont jamais véritablement au repos. Même quand il semble ne rien se passer, c’est une véritable fourmilière à l’intérieur : elles dépensent de l’énergie pour maintenir certaines réactions chimiques en marche tout en bloquant activement beaucoup d’autres. C’est ce travail de l’ombre qui aide les cellules à rester organisées et sélectives.

Une nouvelle étude vient d’ailleurs bousculer ce que l’on croyait savoir, en suggérant que cette utilisation invisible de l’énergie est bien plus importante – et surtout plus structurée – que ce que les scientifiques pensaient auparavant. Les chercheurs ont mis au point une méthode astucieuse pour estimer ce fameux « coût du contrôle cellulaire ». Comment ? En le divisant en deux parties bien distinctes : d’un côté l’énergie utilisée pour soutenir les réactions souhaitées, et de l’autre, celle dépensée pour supprimer celles qui sont indésirables.

Cette approche change radicalement notre vision du métabolisme. Ce n’est plus juste une chaîne d’étapes chimiques ; cela montre que les cellules doivent constamment payer une sorte de tribut énergétique pour maintenir l’ordre dans un environnement moléculaire bruyant et chaotique.

La physique du calme et le coût du silence

Ces travaux fascinants ont été dirigés par Praful Gagrani à l’Université de Tokyo (UTokyo) et offrent une nouvelle grille de lecture pour comparer le prix énergétique de différentes voies métaboliques. Pour bien comprendre, il faut faire un petit détour par la physique. En mécanique classique, les frontières fixes sont gratuites. Si rien ne bouge, aucun travail mécanique n’est effectué, c’est simple. Mais voilà, les cellules vivent dans un monde beaucoup plus bruyant.

Nous sommes ici dans le domaine de la thermodynamique stochastique, où des événements moléculaires aléatoires bousculent constamment les systèmes. Dans ce contexte, le simple fait de maintenir des contraintes stables a un prix. Les cellules doivent continuellement dépenser de l’énergie pour maintenir les frontières chimiques en place, même lorsque rien ne semble changer en apparence. Ce coût se manifeste sous forme de chaleur perdue et de potentiel chimique dissipé. Le système peut sembler stable vu de l’extérieur, mais de l’énergie fuit silencieusement pour le garder ainsi.

Cette lutte remonte loin. Certaines cheminées hydrothermales, situées à près de 9 800 pieds (environ 3 000 mètres) sous la surface, créent des gradients chimiques nets qui ont peut-être alimenté le métabolisme primitif. Une fois les membranes apparues, ces gradients ont pu être piégés, permettant aux premières cellules de garder les molécules utiles à l’intérieur tout en excluant les autres. Maintenir cette différence entre l’intérieur et l’extérieur exigeait de l’énergie. Cela a aussi forcé les systèmes précoces à choisir quelles réactions favoriser et lesquelles supprimer, réduisant le chaos chimique en quelque chose de contrôlable. Dès le début, la vie a payé non seulement pour faire fonctionner la chimie, mais pour la contenir.

Mettre un prix sur les choix de la nature

Dans une prépublication récente, les chercheurs ont introduit une méthode pour noter les voies métaboliques en utilisant la thermodynamique. Ils modélisent une cellule comme un réseau de réactions chimiques – une carte de molécules et de réactions autorisées – piloté par des apports constants. Plutôt que de suivre chaque molécule à la trace, la méthode compare des modèles de voies entières et demande à quel point il est difficile de les maintenir dans le temps. Ce changement de perspective transforme le métabolisme en quelque chose de plus proche d’un problème de physique que d’un exercice de comptabilité.

Le résultat ? Un moyen de comparer les voies sur un pied d’égalité, même lorsque de nombreuses routes mènent du même point de départ au même produit final. Le cadre divise l’improbabilité en deux parties. D’abord, le coût de maintenance, qui mesure combien d’énergie il faut pour soutenir un flux chimique régulier. Ensuite, le coût de restriction, qui capture à quel point il est improbable de réduire au silence les réactions secondaires concurrentes pendant que ce flux persiste. L’addition de ces éléments produit un chiffre unique pour chaque voie.

Un logiciel peut alors énumérer chaque voie chimiquement réalisable reliant une entrée donnée à une sortie et les classer par coût physique plutôt que par intuition. Cette comparaison clarifie le fossé entre ce que la chimie rend possible et ce que la biologie sélectionne réellement. L’évolution choisit le chemin le moins cher. Près de l’équilibre, les coûts des voies se comportent comme des circuits électriques : ajouter des routes parallèles abaisse les barrières semblables à la résistance. Mais loin de l’équilibre, ces règles peuvent se briser. Le même réseau peut inverser les classements ou supporter plusieurs flux stables dans des conditions identiques.

Les catalyseurs, les coûts cachés et la réalité biologique

Les catalyseurs viennent encore compliquer le tableau. Les enzymes peuvent faire paraître une route coûteuse bon marché en dirigeant les réactions vers un produit et loin des autres, réécrivant ainsi efficacement les classements des voies. De plus, faire fonctionner de nombreuses voies à la fois peut générer des sous-produits toxiques, limitant le parallélisme qu’une cellule peut tolérer. En comparant les coûts sous les mêmes entrées, la méthode donne à l’évolution quelque chose de concret à optimiser. Des coûts permanents plus bas laissent plus d’énergie pour la croissance et la réparation – et peuvent expliquer pourquoi le métabolisme moderne n’occupe qu’un coin étroit de ce que la chimie rend possible.

Bien sûr, il faut rester humble face à la complexité du vivant. Les vraies cellules gèrent leur chimie par la régulation des gènes et en ajustant les niveaux d’enzymes, et cette méthode ne capture pas directement cette machinerie. Ajouter des mesures de laboratoire des taux de réaction et des concentrations de métabolites aiderait à ancrer les calculs, surtout pour les réseaux qui opèrent loin de l’équilibre.

Même avec ces limites, le classement des coûts fournit un étalon commun, reliant la physique, la chimie et la biologie dans une seule comparaison. Il montre que les cellules dépensent de l’énergie non seulement pour exécuter les réactions dont elles ont besoin, mais aussi pour supprimer les alternatives qu’elles ne veulent pas. En transformant cette dépense cachée en chiffres, l’approche pourrait aider à guider de futures expériences, tout en rappelant aux chercheurs que les systèmes biologiques paient encore d’autres coûts, plus difficiles à mesurer.

Conclusion : Une nouvelle lecture du vivant

C’est une perspective assez vertigineuse quand on y pense, n’est-ce pas ? L’idée que la vie est autant définie par ce qu’elle empêche que par ce qu’elle produit. Cette étude, qui nous invite à repenser notre conception de l’énergie cellulaire, est publiée dans le Journal of Statistical Mechanics: Theory and Experiment. Elle nous rappelle que derrière le calme apparent de la biologie se cache une dépense constante, un effort perpétuel pour maintenir l’ordre face au chaos universel.

Selon la source : earth.com

Ce contenu a été créé avec l’aide de l’IA.