Un jumeau numérique de la terre est né : Peut-on enfin prédire l’avenir du climat?

Auteur: Adam David

L’œil de verre sur notre planète

C’est un exploit scientifique que des chercheurs allemands viennent de réaliser. Pour la première fois, une équipe de l’Institut Max Planck est parvenue à créer un jumeau numérique de la Terre d’une précision inégalée. L’objectif avoué est de pouvoir modéliser les événements météorologiques et les évolutions climatiques avec une granularité stupéfiante, ouvrant la voie à des prévisions beaucoup plus fines.

Cet outil de simulation est si précis qu’il pourrait révolutionner notre approche face à l’urgence climatique. Cependant, une question cruciale demeure : ce nouvel œil sur le climat sera-t-il accessible à tous, ou restera-t-il le privilège de quelques institutions dotées de moyens colossaux ?

Le saut de l’échelle : De 40 km à 1,25 km

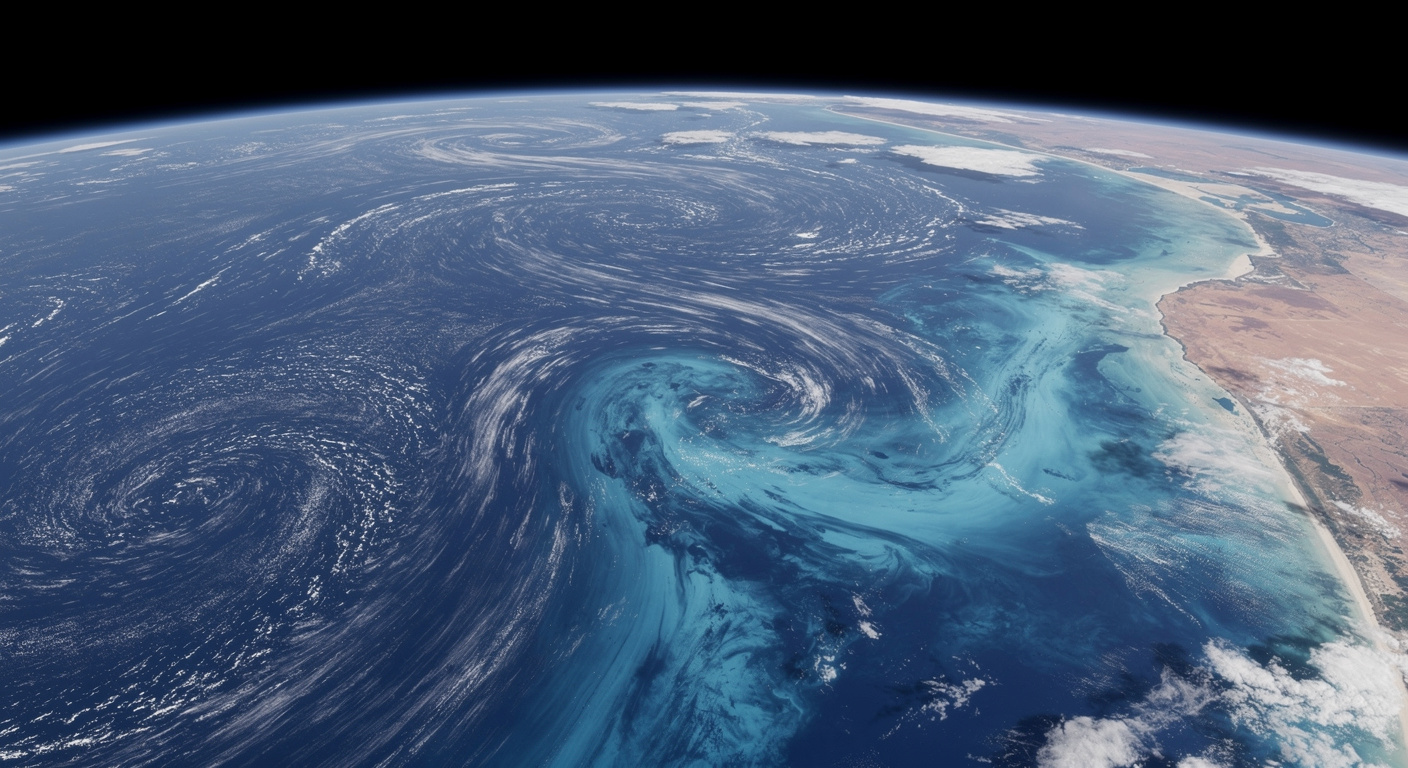

Jusqu’à présent, les meilleurs modèles climatiques et météorologiques peinaient à dépasser une résolution spatiale d’environ 40 kilomètres. Les chercheurs allemands ont pulvérisé cette limite en atteignant une échelle de 1,25 kilomètre. Cet exploit technique est rendu possible par l’intégration de quelque 672 millions de cellules mathématiques, chacune représentant une parcelle précise de l’atmosphère terrestre.

Cette densité est fondamentale. Elle permet en effet de capter des phénomènes locaux qui étaient complètement lissés ou ignorés par les simulations précédentes. Imaginez la différence entre une carte grossière d’un pays et une carte routière extrêmement détaillée : c’est l’écart de performance que représente ce nouveau jumeau numérique.

Un mariage de vitesses : L’intégration des systèmes lents et rapides

L’une des grandes difficultés de la modélisation terrestre réside dans la gestion de systèmes qui évoluent à des rythmes très différents. Les scientifiques ont résolu ce problème en séparant les dynamiques en deux grandes catégories. D’un côté, on trouve les systèmes « rapides », qui régissent les cycles de l’eau et de l’énergie, et qui sont directement liés à la météorologie quotidienne.

De l’autre, il y a les systèmes « lents » : ceux qui impliquent la biosphère, le cycle du carbone et la géochimie complexe des océans. Ces mécanismes, qui s’étendent sur des années ou des décennies, sont essentiels pour comprendre les changements climatiques profonds. Réunir ces deux réalités – des phénomènes rapides comme l’orage et des phénomènes lents comme l’absorption océanique de CO2 – dans un modèle cohérent et à si haute résolution est une première mondiale.

La puissance des supercalculateurs derrière l’exploit

Un tel degré de détail et de complexité ne s’obtient pas sans une puissance de calcul absolument phénoménale. Pour mener à bien leur projet, les chercheurs ont dû s’appuyer sur des outils de pointe, notamment les superordinateurs JUPITER et Alps, installés respectivement en Allemagne et en Suisse.

Le code du modèle avait été initialement écrit dans le langage Fortran, mais pour traiter les gigatonnes de données et gérer les 672 millions de cellules, ils ont exploité le Data-Centric Parallel Programming (DaCe). Grâce à leurs puces ultra-performantes, ces supercalculateurs sont capables de digérer et de modéliser l’évolution de la Terre avec une rapidité et une précision que nous n’aurions pu qu’imaginer il y a quelques années.

Un outil de prévision confiné

Malheureusement, l’extraordinaire performance du jumeau numérique est intrinsèquement liée à la machinerie qui le fait tourner. Le revers de la médaille, c’est que le modèle n’est absolument pas réplicable dans des conditions standard. Il n’est pas question pour l’instant de voir ce logiciel débarquer sur les serveurs d’une station météorologique régionale.

Pour que ce type de modélisation soit accessible au-delà des murs de l’Institut Max Planck – par exemple pour les chercheurs spécialisés ou les agences gouvernementales – il faudrait des investissements massifs dans les infrastructures de supercalcul. Et pas n’importe lesquels : des investissements orientés vers des objectifs purement scientifiques et non lucratifs. C’est le prix d’entrée pour jouer dans la cour de la prédiction climatique à 1,25 km de résolution, et il est très élevé.

Quel avenir pour la démocratisation de la donnée?

La création de ce jumeau numérique marque sans aucun doute un moment décisif dans l’histoire de la modélisation climatique. En combinant la précision du temps court (météo) et la complexité du temps long (climat), l’humanité dispose d’un outil d’anticipation redoutable, capable de simuler des scénarios futurs avec une finesse inédite.

Cependant, si la science a ouvert cette fenêtre exceptionnelle sur l’avenir, la logistique et l’économie risquent d’en restreindre l’usage. Le défi des prochaines années ne sera peut-être pas seulement de raffiner encore ce modèle, mais surtout de trouver les mécanismes institutionnels et financiers pour que cette puissance prédictive puisse véritablement éclairer l’action globale contre le réchauffement climatique.